Nvidia Geforce GTX Titan X

A legerősebb egyprocesszoros gyorsító

- 2. rész - Gyakorlati ismerkedés

Az új gyorsító (és a hozzá tartozó szoftver) tesztmintájának késői kézhezvétele, valamint szerzőnk, Alexei Berillo GTC munkájában való részvétele miatt az áttekintés egyes részei az új Nvidia architektúrájának szentelték. termék és a szintetikus tesztek elemzése később (kb. egy hét múlva) fog megjelenni. Most pedig egy olyan anyagot mutatunk be, amely megismerteti az olvasókkal a videokártya jellemzőivel, valamint a játéktesztek eredményeivel.

Eszköz(ek)

| Nvidia Geforce GTX Titan X 12288MB 384 bites GDDR5 PCI-E | ||

|---|---|---|

| Paraméter | Jelentése | Névleges érték (referencia) |

| GPU | Geforce GTX Titan X (GM200) | |

| Felület | PCI Express x16 | |

| GPU működési frekvencia (ROP), MHz | 1000—1075 | 1000—1075 |

| Memória frekvencia (fizikai (effektív)), MHz | 1750 (7000) | 1750 (7000) |

| Memóriacsere busz szélessége, bit | 384 | |

| A számítási egységek száma a GPU-ban / a blokkok frekvenciája, MHz | 24/1000—1075 | 24/1000—1075 |

| Műveletek száma (ALU) blokkonként | 128 | |

| Összes művelet (ALU) | 3072 | |

| Textúra egységek száma (BLF/TLF/ANIS) | 192 | |

| Raszterezési blokkok száma (ROP) | 96 | |

| Méretek, mm | 270×100×35 | 270×100×35 |

| A videokártya által elfoglalt nyílások száma a rendszeregységben | 2 | 2 |

| Textolit szín | fekete | fekete |

| Energiafogyasztás (csúcs 3D-ben/2D módban/alvó üzemmódban), W | 257/98/14 | 257/98/14 |

| Zajszint (2D módban / 2D módban (videolejátszás) / maximum 3D módban), dBA | 20/21/29,5 | — |

| Kimeneti csatlakozók | 1×DVI (Dual-Link/HDMI), 1×HDMI 2.0, 3×DisplayPort 1.2 | |

| Többfeldolgozás támogatása | SLI | |

| A vevők/monitorok maximális száma az egyidejű képkimenethez | 4 | 4 |

| Segédteljesítmény: 8 tűs csatlakozók száma | 1 | 1 |

| Segédteljesítmény: 6 tűs csatlakozók száma | 1 | 1 |

| Maximális 2D felbontás: DP/HDMI/Dual-Link DVI/Single-Link DVI | ||

| Maximális 3D felbontás: DP/HDMI/Dual-Link DVI/Single-Link DVI | 3840×2400/3840×2400/2560×1600/1920×1200 | |

| Helyi memóriával együtt | ||

|---|---|---|

A kártya 12288 MB GDDR5 SDRAM-mal rendelkezik 24 db 4 Gb-os lapkában (12 db a PCB mindkét oldalán). A DirectX 11 szintetikus tesztjeként a Microsoft és az AMD SDK-kból, valamint az Nvidia demóprogramjából származó példákat használtunk. Az első a HDRToneMappingCS11.exe és az NBodyGravityCS11.exe a DirectX SDK-ból (2010. február). Mindkét videochip-gyártótól is vettünk pályázatokat: az Nvidiától és az AMD-től. A DetailTessellation11 és a PNTtriangles11 az ATI Radeon SDK-ból származnak (ezek a DirectX SDK-ban is megtalálhatók). Ezenkívül az Nvidia Realistic Water Terrain demóprogramját, más néven Island11-et használták. Szintetikus teszteket a következő videokártyákon végeztek:

A Geforce GTX Titan X videokártya új modelljének teljesítményének elemzéséhez a következő okok miatt választották ezeket a megoldásokat. A Geforce GTX 980 ugyanolyan Maxwell architektúrájú, de alacsonyabb szintű - GM204 - grafikus processzorra épül, és nagyon érdekes lesz számunkra, hogy értékeljük, mit adott a chip bonyolultsága a GM200 számára. Nos, a Geforce GTX Titan Z kétchipes videokártyát csak referenciaként vettük – mint a legproduktívabb Nvidia videokártyát, amely a korábbi Kepler architektúra GK110-es lapkáján alapul. A rivális AMD cégtől két grafikus kártyát is választottunk összehasonlításunkhoz. Elvileg nagyon különböznek egymástól, bár ugyanazokra a Hawaii GPU-kra épülnek – csak más a GPU-k száma a kártyákon, és eltér egymástól a pozicionálás és az ár. A Geforce GTX Titan X-nek nincs árversenytársa, ezért a legerősebb Radeon R9 295X2 kétchipes videokártyát választottuk, bár egy ilyen összehasonlítás technikailag nem lenne túl érdekes. Utóbbihoz a versenytárs leggyorsabb egychipes videokártyáját, a Radeon R9 290X-et vették, bár túl régen adták ki, és egyértelműen kisebb bonyolultságú GPU-ra épül. De egyszerűen nincs más választás az AMD megoldások közül. Direct3D 10: PS 4.0 pixel shader tesztek (textúrázás, loopolás)Elhagytuk az elavult DirectX 9 benchmarkokat, mivel az olyan szupererős megoldások, mint a Geforce GTX Titan X nem mutatnak túl jó eredményeket bennük, mivel mindig korlátozza a memória sávszélessége, a kitöltési sebesség vagy a textúra. Arról nem is beszélve, hogy a kétchipes videokártyák nem mindig működnek megfelelően az ilyen alkalmazásokban, nálunk kettő is van. A RightMark3D második verziója két már ismert PS 3.0 tesztet tartalmaz Direct3D 9 alatt, amelyeket átírtak DirectX 10-re, valamint további két új tesztet. Az első pár hozzáadta az önárnyékolás és a shader szupermintavételezés lehetőségét, ami ráadásul növeli a videochipek terhelését. Ezek a tesztek a hurkolt pixel-shaderek teljesítményét mérik nagyszámú textúramintával (akár több száz mintával képpontonként a legnehezebb módban) és viszonylag kis ALU-terheléssel. Más szóval, mérik a textúra lekérésének sebességét és az elágazás hatékonyságát a pixel shaderben. Az első pixel shader teszt a Fur lesz. A legalacsonyabb beállításoknál 15-30 textúramintát használ a magasságtérképből és két mintát a fő textúrából. Az Effect detail - "High" mód 40-80-ra növeli a minták számát, a "shader" szuperminta beépítése - akár 60-120 mintára, a "High" módot pedig az SSAA-val együtt a maximális "súlyosság" jellemzi. - 160-320 minta a magassági térképről. Először nézzük meg azokat a módokat, amelyekben nincs engedélyezve a szupermintavétel, ezek viszonylag egyszerűek, és az „Alacsony” és „Magas” módban elért eredmények arányának megközelítőleg azonosnak kell lennie.

Ebben a tesztben a teljesítmény a TMU-k számától és hatékonyságától függ, és az összetett programok végrehajtásának hatékonysága is befolyásolja. A szupermintavételezés nélküli változatban pedig a tényleges kitöltési sebesség és a memória sávszélessége is további hatással van a teljesítményre. A „Magas” szint részletezésekor az eredmények akár másfélszer alacsonyabbak, mint az „alacsony” értéknél. A nagyszámú textúrakiválasztással járó procedurális szőrmegjelenítés feladataiban, a GCN architektúrára épülő videochipek kiadásával az AMD már régen magához ragadta a vezetést. Ezekben az összehasonlításokban a mai napig a Radeon kártyák a legjobbak, ami azt jelzi, hogy hatékonyabban hajtják végre ezeket a programokat. Ezt a következtetést a mai összehasonlítás is megerősíti – az általunk vélt Nvidia videokártya még az elavult egychipes Radeon R9 290X-hez képest is elveszett, nem is beszélve az AMD legközelebbi árversenytársáról. Az első Direct3D 10 tesztben a Geforce GTX Titan X modell új videokártyája egy kicsivel gyorsabbnak bizonyult, mint a GTX 980 képében lévő azonos architektúrájú chipen lévő húga, de az utóbbi már nincs messze. mögött - 9-12%. Ez az eredmény a GTX 980 érezhetően alacsonyabb textúrázási sebességével magyarázható, más paraméterekben pedig elmarad, bár egyértelműen nem az ALU-k teljesítménye számít. A kétchipes Titan Z gyorsabb, de nem olyan gyors, mint a Radeon R9 295X2. Nézzük ugyanennek a tesztnek az eredményét, de bekapcsolt "shader" szupermintavétel mellett, ami megnégyszerezi a munkát: ilyen helyzetben valaminek változnia kell, és a memória sávszélessége kitöltési sebességgel kisebb hatással lesz:

Nehéz körülmények között a Geforce GTX Titan X modell új videokártyája már észrevehetően megelőzi az azonos generáció fiatalabb modelljét - a GTX 980-at, tisztességes 33-39%-kal gyorsabb, ami sokkal közelebb áll az elméleti különbséghez. közöttük. A versenytársak lemaradása pedig a Radeon R9 295X2 és R9 290X formájában csökkent – az Nvidia új terméke majdnem utolérte az egychipes Radeont. A kétlapkás azonban jóval előrébb tart, mert az AMD chipek jobban kedvelik a pixelenkénti számításokat, és nagyon erősek az ilyen számításokban. A következő DX10-teszt az összetett hurkos pixel-shaderek végrehajtásának teljesítményét méri nagyszámú textúra lekéréssel, és az úgynevezett Meredek Parallax Mapping. Alacsony beállításoknál 10-50 textúramintát használ a magasságtérképből és három mintát a fő textúrákból. Ha bekapcsolja a nehéz módot önárnyékolással, a minták száma megduplázódik, a szupermintavétel pedig megnégyszerezi ezt a számot. A legbonyolultabb tesztmód szupermintavételezéssel és önárnyékolással 80-400 textúraértéket választ ki, vagyis nyolcszor többet, mint az egyszerű mód. Először ellenőrizzük az egyszerű opciókat szupermintavétel nélkül:

A második Direct3D 10 pixeles shader teszt gyakorlati szempontból érdekesebb, mivel a parallaxis leképezési változatokat széles körben használják a játékokban, míg a nehéz változatokat, mint például a meredek parallaxis leképezést, régóta használják számos projektben, például a Crysisben, Lost Planet és sok más játék. Ráadásul tesztünkben a szupermintavétel mellett bekapcsolható az önárnyékolás, ami körülbelül kétszeresére növeli a videochip terhelését - ezt a módot "High"-nek hívják. A diagram általánosságban hasonló az előzőhöz, szintén szupermintavétel nélkül, és ezúttal az új Geforce GTX Titan X kicsit közelebb áll a GTX Titan Z-hez, nem annyira veszítve a két chipes alaplappal szemben. egy pár Kepler család GPU-n. V különböző feltételek az új termék 14-19%-kal előzi meg az Nvidia jelenlegi generációjának korábbi csúcsmodelljét, és még ha az AMD videokártyákkal is összehasonlítjuk, itt valami megváltozott - ebben az esetben az új GTX Titan X valamivel alulmarad. a Radeon R9 290X-hez eléggé. A kétchipes R9 295X2 azonban messze mindenki előtt jár. Lássuk, mi változtatja meg a szupermintavételezést:

A szupermintavétel és az önárnyékolás engedélyezése esetén a feladat nehezedik, két lehetőség együttes beépítése egyszerre csaknem nyolcszorosára növeli a kártyák terhelését, komoly teljesítménycsökkenést okozva. A tesztelt videokártyák sebességjelzői között némileg változott a különbség, bár a szupermintavétel beépítése kisebb hatást fejt ki, mint az előző esetben. Az AMD Radeon grafikus megoldások jobban teljesítenek, mint a versengő Geforce kártyák ebben a D3D10 pixel shader tesztben, de az új GM200 chip megváltoztatja a helyzetet jobb oldala- a Maxwell architektúra chipre épülő Geforce GTX Titan X lap már minden körülmények között megelőzi a Radeon R9 290X-et (azonban egy érezhetően kevésbé bonyolult GPU alapján). A Hawaii párosra épülő kétchipes megoldás továbbra is a vezető, de a többi Nvidia megoldáshoz képest nem rossz az új termék. Szinte a kétlapkás Geforce GTX Titan Z szintjén mutatott sebességet, és 28-33%-kal felülmúlta a Geforce GTX 980-at. Direct3D 10: PS 4.0 Pixel Shader összehasonlítási alapjai (számítástechnika)A következő néhány pixel shader teszt tartalmazza a minimális számú textúra lekérést, hogy csökkentse a TMU teljesítményének hatását. Nagyszámú aritmetikai műveletet alkalmaznak, és pontosan mérik a videochipek matematikai teljesítményét, az aritmetikai utasítások végrehajtási sebességét a pixel shaderben. Az első matematikai teszt ásványi anyag. Ez egy összetett eljárási textúrázási teszt, amely csak két textúra adatmintát és 65 sin és cos utasítást használ.

A limitáló matematikai tesztek eredményei leggyakrabban megfelelnek a frekvenciák és a számítási egységek számának különbségének, de csak hozzávetőlegesen, hiszen az eredményeket befolyásolja az egyes feladatokban való felhasználásuk eltérő hatékonysága, illetve a meghajtók optimalizálása, illetve a legfrissebb gyakoriság ill. energiagazdálkodási rendszerek, és még a memória sávszélességének hangsúlyozása is. A Mineral teszt esetében az új Geforce GTX Titan X modell mindössze 10%-kal gyorsabb, mint az azonos generációból származó GM204 chipre épülő GTX 980-as kártya, és a kétchipes GTX Titan Z sem volt olyan gyors ebben a tesztben. - Valami egyértelműen gátolja az Nvidia kártyák megnyitását. A Geforce GTX Titan X és az AMD versengő alaplapjainak összehasonlítása nem lenne olyan szomorú, ha az R9 290X és a Titan X GPU-i bonyolultságukat tekintve közel állnak egymáshoz. De a GM200 sokkal nagyobb, mint a Hawaii, és a kis győzelme teljesen természetes. Az Nvidia Keplerről Maxwellre való architektúra-frissítése révén az új lapkák közelebb kerültek a konkurens AMD-megoldásokhoz az ilyen tesztekben. De még az olcsóbb, kétchipes megoldású Radeon R9 295X2 is érezhetően gyorsabb. Nézzük a shader számítások második tesztjét, amelyet Fire-nek hívnak. Az ALU-hoz nehezebb, és csak egy texture fetch van benne, a sin és cos utasítások száma pedig megduplázódott, 130-ra. Lássuk, mi változott a terhelés növekedésével:

A RigthMark második matematikai tesztjében már különböző eredményeket látunk a videokártyákra egymáshoz képest. Tehát az új Geforce GTX Titan X már erősebb (20%-kal) megelőzi a GTX 980-at egy ugyanolyan grafikus architektúrájú chipen, és a kétlapkás Geforce nagyon közel áll az új termékhez - Maxwell sokkal jobban megbirkózik a számítási feladatokkal. jobb, mint Kepler. Lemaradt a Radeon R9 290X, de ahogy már írtuk, a Hawaii GPU érezhetően egyszerűbb, mint a GM200, és ez a különbség logikus. De bár a kétchipes Radeon R9 295X2 továbbra is vezető szerepet tölt be a matematikai tesztekben, általában az új Nvidia videochip jól teljesített az ilyen feladatokban, bár nem érte el az elméleti különbséget a GM204-hez képest. Direct3D 10: Geometry Shader tesztekA RightMark3D 2.0-ban két geometriai árnyékoló sebességteszt létezik, az első opció neve "Galaxy", a technika hasonló a Direct3D korábbi verzióinak "pont spritejéhez". Egy részecskerendszert animál a GPU-n, minden pontból egy geometriai árnyékoló négy csúcsot hoz létre, amelyek részecskéket alkotnak. Hasonló algoritmusokat széles körben kell használni a jövőbeni DirectX 10 játékokban. A geometria shader teszteknél az egyensúly megváltoztatása nem befolyásolja a végeredményt, a végső kép mindig pontosan ugyanaz, csak a jelenetfeldolgozási módok változnak. A "GS load" paraméter határozza meg, hogy melyik shaderben történjen a számítás – csúcsban vagy geometriában. A számítások száma mindig azonos. Tekintsük a „Galaxy” teszt első verzióját a vertex shaderben végzett számításokkal a geometriai összetettség három szintjére:

A jelenetek különböző geometriai bonyolultságú sebességeinek aránya minden megoldásnál megközelítőleg azonos, a teljesítmény a pontok számának felel meg, minden lépésnél közel kétszeres az FPS-esés. Ez a feladat nagyon egyszerű a nagy teljesítményű modern videokártyák esetében, és a teljesítményt ebben korlátozza a geometriai feldolgozás sebessége, és néha a memória sávszélessége és/vagy kitöltési sebessége. Az Nvidia és AMD chipekre épülő videokártyák eredményei közötti különbség általában a kaliforniai cég megoldásainak kedvez, ennek oka pedig az, hogy ezen cégek chipjeinek geometriai csővezetékei eltérőek. A legjobb Nvidia videochipek ebben az esetben is sok geometriai feldolgozó egységgel rendelkeznek, így a nyereség nyilvánvaló. A geometriai tesztek során a Geforce kártyák mindig versenyképesebbek, mint a Radeon. Az új Geforce GTX Titan X modell némileg lemarad az előző generációs GPU-k kétchipes GTX Titan Z kártyájától, de 12-25%-kal felülmúlja a GTX 980-at. A Radeon grafikus kártyák markánsan eltérő eredményeket mutatnak, az R9 295X2 ugyanis egy pár GPU-ra épül, és ebben a tesztben csak ez tudja felvenni a versenyt az újdonsággal, a Radeon R9 290X pedig kívülálló volt. Nézzük meg, hogyan változik a helyzet, amikor a számítások egy részét átvisszük a geometria árnyékolóba:

Amikor a terhelés megváltozott ebben a tesztben, a számok kissé megváltoztak az AMD kártyák és az Nvidia megoldások esetében. És ez nem igazán változtat semmin. A geometriai árnyékolók ezen tesztjében szereplő videokártyák rosszul reagálnak a GS terhelési paraméterének változásaira, amely a számítások egy részének átviteléért felelős a geometria árnyékolóba, így a következtetések ugyanazok maradnak. Sajnos a "Hyperlight" a geometria-shaderek második tesztje, amely egyszerre több technika használatát mutatja be: példányosítás, stream-kimenet, pufferterhelés, amely dinamikus geometria létrehozását használja két pufferre való rajzolással, valamint egy új Direct3D 10 funkció - stream kimenet, minden modern AMD grafikus kártya egyszerűen nem működik. Valamikor egy másik Catalyst illesztőprogram-frissítés miatt ez a teszt leállt a Catalyst kártyákon, és ezt már évek óta nem javították. Direct3D 10: textúra lekérési sebesség a vertex shaderekbőlA "Vertex Texture Fetch" tesztek nagyszámú textúra lekérésének sebességét mérik egy vertex shaderből. A tesztek lényegét tekintve hasonlóak, tehát a „Föld” és a „Hullámok” tesztben a kártyák eredményei közötti aránynak megközelítőleg azonosnak kell lennie. Mindkét teszt textúra mintavételi adatokon alapuló eltolásleképezést használ, az egyetlen lényeges különbség, hogy a "Waves" teszt feltételes ugrásokat használ, míg a "Föld" teszt nem. Tekintsük az első „Föld” tesztet, először „Effect Detail Low” módban:

Korábbi vizsgálataink kimutatták, hogy a kitöltési sebesség és a memória sávszélessége is befolyásolhatja ennek a tesztnek az eredményét, ami jól látható az Nvidia kártyák eredményein, különösen egyszerű módokban. Az Nvidia új videokártyája ebben a tesztben egyértelműen alacsonyabb sebességet mutat, mint kellene - az összes Geforce kártya megközelítőleg azonos szintűnek bizonyult, ami egyértelműen nem felel meg az elméletnek. Minden módban egyértelműen olyan dolgokba futnak bele, mint a memória sávszélessége. A Radeon R9 295X2 azonban közel sem kétszer olyan gyors, mint az R9 290X. Egyébként ezúttal az AMD egylapkás kártyája erősebbnek bizonyult, mint az összes Nvidia kártyája light módban, és megközelítőleg annak szintjén kemény módban. Nos, ismét a kétchipes Radeon R9 295X2 lett összehasonlításunk vezetője. Nézzük meg a teljesítményt ugyanabban a tesztben, megnövekedett számú textúralekéréssel:

A diagramon látható helyzet némileg változott, az AMD egylapkás megoldása nehéz módokban lényegesen több Geforce kártyát veszített. Az új Geforce GTX Titan X modell akár 14%-kal gyorsabb sebességet mutatott, mint a Geforce GTX 980, és a legkönnyebb mód kivételével minden módban felülmúlta az egylapkás Radeont – valamire ugyanaz a fókusz miatt. Ha az új terméket az AMD dual-chipes megoldásával hasonlítjuk össze, akkor a Titan X szoros teljesítményt felmutató, de light módban lemaradva tudott harcolni heavy módban. Tekintsük a vertex shaderekből származó textúra lekérések második tesztjének eredményeit. A Waves teszt kevesebb mintát tartalmaz, de feltételes ugrásokat használ. A bilineáris textúra minták száma ebben az esetben csúcsonként legfeljebb 14 ("Effect detail Low") vagy 24 ("Effect detail High") lehet. A geometria összetettsége az előző teszthez hasonlóan változik.

A második "Waves" vertex textúrázási teszt eredményei semmiben sem hasonlítanak az előző diagramokon látottakhoz. Az összes Geforce sebességi teljesítménye ebben a tesztben súlyosan leromlott, és az új Nvidia Geforce GTX Titan X modell csak valamivel gyorsabb sebességet mutat, mint a GTX 980, lemaradva a kétchipes Titan Z mögött. A versenytársakhoz képest mindkét Radeon kártya képes volt hogy minden üzemmódban a legjobb teljesítményt mutassák ebben a tesztben. Tekintsük ugyanezen probléma második változatát:

A feladat összetettségével a második textúra-mintavételi tesztben minden megoldás sebessége csökkent, de az Nvidia videokártyák jobban szenvedtek, így a vizsgált modell is. Szinte semmi sem változik a következtetésekben, az új Geforce GTX Titan X modell akár 10-30%-kal gyorsabb, mint a GTX 980, lemaradva mind a kétchipes Titan Z, mind a Radeon kártyák mögött. A Radeon R9 295X2 messze előrébb jár ezekben a tesztekben, és elméleti szempontból ez egyszerűen megmagyarázhatatlan, kivéve az Nvidia elégtelen optimalizálását. 3DMark Vantage: FunkciótesztekA 3DMark Vantage csomagból származó szintetikus tesztek megmutatják, miről maradtunk le korábban. Az ebből a tesztcsomagból származó szolgáltatástesztek DirectX 10 támogatással rendelkeznek, továbbra is relevánsak és érdekesek, mert eltérnek a miénktől. A csomagban található legújabb Geforce GTX Titan X videokártya eredményeit elemezve néhány olyan új és hasznos következtetést vonunk le, amelyek a RightMark család csomagjaiból származó tesztek során elkerültek bennünket. 1. jellemző teszt: Textúra kitöltésAz első teszt a textúra lekérő egységek teljesítményét méri. Egy téglalap kitöltésére szolgál egy kis textúrából kiolvasott értékekkel, több textúrakoordinátával, amelyek minden képkockát megváltoztatnak.

Az AMD és Nvidia videokártyák hatékonysága a Futuremark textúra tesztjében meglehetősen magas, a különböző modellek végső számai pedig közel állnak a megfelelő elméleti paraméterekhez. A GTX Titan X és a GTX 980 közötti sebességkülönbség tehát 38%-os volt a GM200-ra épülő megoldás javára, ami közel áll az elmélethez, ugyanis az új termék másfélszer több TMU-t tartalmaz. , de alacsonyabb frekvencián működnek. Természetesen megmarad a lemaradás a dual-GTX Titan Z mögött, hiszen a két GPU gyorsabb textúrájú. Ami az új csúcs Nvidia videokártya textúrázási sebességének összehasonlítását illeti a versenytárs hasonló árú megoldásaival, itt az újdonság alulmúlja a kétchipes riválist, amely ugyan feltételes szomszéd az árrésben, de megelőzi a Radeon R9 290X, bár nem túl sok. Ennek ellenére az AMD grafikus kártyák még mindig jobban teljesítenek a textúrázás terén. 2. szolgáltatásteszt: SzínkitöltésA második feladat a kitöltési arány teszt. Nagyon egyszerű pixel shader-t használ, amely nem korlátozza a teljesítményt. Az interpolált színértéket a rendszer egy képernyőn kívüli pufferbe (renderelési cél) írja alfa keveréssel. 16 bites FP16 képernyőn kívüli puffert használ, ami a leggyakrabban használt HDR-megjelenítést használó játékokban, így ez a teszt meglehetősen időszerű.

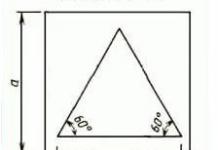

A második 3DMark Vantage alteszt számai a ROP egységek teljesítményét mutatják, a videómemória sávszélességének (ún. "effective fillrate") figyelembevétele nélkül, a teszt pedig pontosan a ROP teljesítményét méri. A ma áttekintett Geforce GTX Titan X kártya észrevehetően megelőzi mindkét Nvidia kártyát, a GTX 980-at és még a GTX Titan Z-t is, és akár 45%-kal is felülmúlja a GM204 alapú egylapkás kártyát – a ROP-ok számát és azok számát tekintve. A Maxwell architektúra csúcs GPU-jának hatékonysága kiváló! És ha összehasonlítjuk az új Geforce GTX Titan X videokártya jelenetkitöltési sebességét az AMD videokártyákkal, akkor a tesztben vizsgált Nvidia kártya mutatja a legjobb jelenetkitöltési sebességet még a legerősebb kétchipes Radeon R9-hez képest is. 295X2, nem beszélve a jelentősen lemaradt Radeon R9 290X-ről. A nagyszámú ROP blokk és a framebuffer adattömörítés hatékonyságát szolgáló optimalizálás elvégezte a feladatát. 3. jellemző teszt: Parallax okklúziós leképezésAz egyik legérdekesebb funkcióteszt, mivel ezt a technikát már használják a játékokban. Egy négyszöget (pontosabban két háromszöget) rajzol a speciális, összetett geometriát utánzó Parallax Occlusion Mapping technikával. Meglehetősen erőforrás-igényes sugárkövetési műveleteket és nagy felbontású mélységtérképet használnak. Ezt a felületet is árnyékolják a nehéz Strauss-algoritmus segítségével. Ez egy nagyon összetett és nehéz pixel shader tesztje egy videochiphez, amely számos textúra lekérést tartalmaz sugárkövetés, dinamikus elágazás és összetett Strauss-világítási számítások során.

Ez a 3DMark Vantage csomagból származó teszt annyiban különbözik a korábbiaktól, hogy a benne lévő eredmények nem csak a matematikai számítások sebességétől, az elágazás-végrehajtás hatékonyságától, vagy a textúrák lekérésének sebességétől függenek, hanem egyszerre több paramétertől is. A feladat nagy sebességének eléréséhez fontos a GPU megfelelő egyensúlya, valamint az összetett shaderek végrehajtásának hatékonysága. Ebben az esetben mind a matematikai, mind a textúra teljesítménye fontos, és ebben a 3DMark Vantage "szintetikában" az új Geforce GTX Titan X kártya több mint harmadával gyorsabbnak bizonyult, mint az azonos Maxwell architektúrájú GPU-n alapuló modell. . És még a kétchipes Kepler is a GTX Titan Z képében kevesebb mint 10%-kal felülmúlta az újdonságot. Az Nvidia egylapkás felső kategóriás kártyája egyértelműen felülmúlta az egychipes Radeon R9 290X-et ebben a tesztben, de mindkettőt komolyan felülmúlja a kétchipes Radeon R9 295X2. Az AMD GPU-i ebben a feladatban valamivel hatékonyabbak, mint az Nvidia chipek, és az R9 295X2-ben kettő van belőlük. 4. szolgáltatásteszt: GPU-szövetA negyedik teszt azért érdekes, mert egy videochip segítségével számítja ki a fizikai kölcsönhatásokat (szövetimitáció). Csúcsszimulációt alkalmazunk, a vertex és a geometria shader kombinált működésével, több lépéssel. Használja a stream out-ot a csúcsok egyik szimulációs lépésből a másikba való átviteléhez. Így teszteljük a csúcs- és geometria-shaderek végrehajtásának teljesítményét és a kiáramlási sebességet.

A renderelési sebesség ebben a tesztben is több paramétertől függ egyszerre, és a fő befolyásoló tényező a geometria-feldolgozás teljesítménye és a geometria árnyékolók hatékonysága. Azaz az Nvidia chipek erősségei meg kellene, hogy látszódjanak, de sajnos - nagyon furcsa eredményt láttunk (újraellenőrzve), az új Nvidia videokártya finoman szólva sem mutatott túl nagy sebességet. A Geforce GTX Titan X ebben a résztesztben az összes megoldás közül a legrosszabb eredményt mutatta, még a GTX 980-tól is csaknem 20%-kal lemaradva! Nos, a Radeon lapokkal való összehasonlítás ebben a tesztben ugyanolyan csúnya egy új termék esetében. Annak ellenére, hogy elméletileg kisebb számban vannak geometriai végrehajtó egységek, és az AMD chipek geometriai teljesítménybeli lemaradása a konkurens megoldásokhoz képest, mindkét Radeon kártya nagyon hatékonyan működik ebben a tesztben, és összehasonlításban felülmúlja mindhárom bemutatott Geforce kártyát. Ismét úgy tűnik, hogy az Nvidia illesztőprogramjaiban nincs optimalizálva egy adott feladathoz. 5. szolgáltatásteszt: GPU részecskékTeszt az effektusok fizikai szimulálására videochip segítségével kiszámított részecskerendszereken. Csúcsszimulációt is alkalmaznak, minden csúcs egyetlen részecskét képvisel. A Stream out ugyanarra a célra használható, mint az előző tesztben. Több százezer részecskét számítanak ki, mindegyiket külön animálják, és a magassági térképpel való ütközésüket is kiszámítják. Hasonlóan az egyik RightMark3D 2.0 tesztünkhöz, a részecskéket egy geometria árnyékolóval rajzoljuk meg, amely minden pontból négy csúcsot hoz létre a részecske kialakításához. De a teszt leginkább a shader blokkokat tölti be vertex számításokkal, a stream out is tesztelésre kerül.

A 3DMark Vantage második "geometrikus" tesztjén a helyzet alaposan megváltozott, ezúttal már minden Geforce többé-kevésbé normális eredményt mutat, bár a kétchipes Radeon továbbra is az élen marad. Az új GTX Titan X modell 24%-kal gyorsabb, mint testvére, a GTX 980, és nagyjából ugyanennyivel elmarad az előző generációs GPU-n lévő, kettős GPU-s Titan Z-től. Az Nvidia újdonságának összehasonlítása az AMD versengő videokártyáival ezúttal pozitívabb – a rivális cég két kártyája között mutatta meg az eredményt, és kiderült, hogy közelebb áll a két GPU-s Radeon R9 295X2-höz. Az újdonság messze megelőzi a Radeon R9 290X-et, és ez jól mutatja, hogy mennyire különbözik egymástól a két látszólag hasonló teszt: a szövetszimuláció és a részecskerendszer szimuláció. 6. szolgáltatásteszt: Perlin-zajA Vantage csomag utolsó funkciótesztje a videochip matematikailag intenzív tesztje, a Perlin zajalgoritmus több oktávját számolja ki a pixel shaderben. Mindegyik színcsatorna saját zajfunkciót használ a videochip terhelésének növelésére. A Perlin zaj egy szabványos algoritmus, amelyet gyakran használnak a procedurális textúrában, sok matematikai számítást használ.

Ebben az esetben a megoldások teljesítménye nem egészen egyezik az elmélettel, bár közel áll ahhoz, amit a hasonló teszteknél láttunk. A Futuremark csomagból származó matematikai tesztben, amely a videochipek csúcsteljesítményét mutatja limitfeladatokban, az eredmények eltérő eloszlását látjuk a tesztcsomagunk hasonló tesztjeihez képest. Régóta tudjuk, hogy a GCN architektúrájú AMD videochipek még mindig jobban megbirkóznak az ilyen feladatokkal, mint a versenytársak megoldásai, különösen olyan esetekben, amikor intenzív „matematika” történik. De az Nvidia új csúcsmodellje a nagy GM200 chipre épül, így a Geforce GTX Titan X észrevehetően jobban teljesített, mint a Radeon R9 290X ebben a tesztben. Ha az újdonságot a Geforce GTX 900 család legjobb modelljével hasonlítjuk össze, akkor ebben a tesztben közel 40%-os volt a különbség köztük - természetesen a ma mérlegelendő videókártya javára. Ez is közel áll az elméleti különbséghez. Nem rossz eredmény a Titan X-től, csak a kétchipes Radeon R9 295X2 volt előrébb, és messze is. Direct3D 11: Shaderek számításaAz Nvidia nemrégiben kiadott csúcsminőségű megoldásának teszteléséhez a DirectX 11 szolgáltatásait, például a tessellációt és a számítási árnyékolókat használó feladatokhoz a Microsoft, az Nvidia és az AMD SDK-példáit és demóit használtuk. Először is megvizsgáljuk a Compute shadereket használó benchmarkokat. Megjelenésük az egyik legfontosabb újítás a DX API legújabb verzióiban, már a modern játékokban is alkalmazzák különféle feladatok elvégzésére: utófeldolgozás, szimuláció, stb. a DirectX SDK-ból, utófeldolgozással, amely pixel- és számítási árnyékolókat használ.

A számítások sebessége a számítási és pixel shaderben az összes AMD és Nvidia kártya esetében megközelítőleg azonos, eltérést csak a korábbi architektúrák GPU-jain alapuló videokártyáknál figyeltek meg. Korábbi tesztjeink alapján egy probléma eredménye gyakran nem annyira a matematikai teljesítménytől és a számítási hatékonyságtól függ, hanem más tényezőktől, például a memória sávszélességétől. Ebben az esetben az új csúcskategóriás grafikus kártya gyorsabb, mint az egylapkás Geforce GTX 980 és Radeon R9 290X változatok, de mögötte a kétchipes R9 295X2, ami érthető, mert egy pár R9 ereje van. 290X. Ha az új terméket a Geforce GTX 980-hoz hasonlítjuk, akkor a ma számításba vett kaliforniai cég alaplapja 34-36%-kal gyorsabb - pontosan az elmélet szerint. A második számítási árnyékoló teszt szintén a Microsoft DirectX SDK-ból származik, és egy N-test (N-test) gravitációs számítási problémát mutat be, egy dinamikus részecskerendszer szimulációját, amely fizikai erőknek, például gravitációnak van kitéve.

Ebben a tesztben leggyakrabban az összetett matematikai számítások végrehajtásának gyorsaságán, a geometriai feldolgozáson és az elágazásos kódvégrehajtás hatékonyságán van a hangsúly. Ebben a DX11-es tesztben pedig teljesen eltérőnek bizonyult az erőkiosztás két különböző cég megoldása között - egyértelműen a Geforce videokártyák javára. A különböző lapkákra épülő Nvidia-megoldások páros eredményei azonban szintén furcsaak - a Geforce GTX Titan X és a GTX 980 szinte megegyezik, mindössze 5%-os teljesítménykülönbség választja el őket egymástól. A kétchipes renderelés nem működik ebben a feladatban, így a riválisok (egylapkás és kétlapkás Radeon modellek) nagyjából azonos sebességűek. Nos, a GTX Titan X háromszor is megelőzi őket. Úgy tűnik, hogy ezt a feladatot sokkal hatékonyabban lehet kiszámítani a Maxwell architektúrájú GPU-kon, amit korábban megjegyeztünk. Direct3D 11: Tessellation PerformanceA számítási árnyékolók nagyon fontosak, de a Direct3D 11 másik jelentős újdonsága a hardveres tesszelláció. Az Nvidia GF100-ról szóló elméleti cikkünkben részletesen megvizsgáltuk. A Tessellationt régóta használják DX11 játékokban, mint például a STALKER: Call of Pripyat, DiRT 2, Aliens vs Predator, Metro Last Light, Civilization V, Crysis 3, Battlefield 3 és mások. Némelyikük tesszellációt használ karaktermodellekhez, mások valósághű vízfelületet vagy tájat szimulálnak. Számos különböző séma létezik a grafikus primitívek particionálására (tesselláció). Például phong tesselláció, PN háromszögek, Catmull-Clark felosztás. Tehát a PN-háromszögek csempézési sémáját a STALKER: Call of Pripyat és a Metro 2033 - Phong tessellációban használják. Ezek a módszerek viszonylag gyorsan és egyszerűen beépíthetők a játékfejlesztési folyamatba és a meglévő motorokba, ezért váltak népszerűvé. Az első tessellációs teszt az ATI Radeon SDK-ból származó Detail Tessellation példa lesz. Nemcsak tesszellációt valósít meg, hanem két különböző pixelenkénti feldolgozási technikát is: a normál térképek egyszerű átfedését és a parallaxis okklúziós leképezést. Nos, hasonlítsuk össze az AMD és az Nvidia DX11 megoldásait különböző körülmények között:

Az egyszerű bumpmapping tesztnél a táblák sebessége nem túl fontos, mivel ez a feladat már régóta túl egyszerűvé vált, és a teljesítmény a memória sávszélességétől vagy kitöltési sebességétől függ. A felülvizsgálat mai hőse 23%-kal megelőzi a korábbi, GM204 chipre épülő Geforce GTX 980 csúcsmodellt, és kissé alulmúlja versenytársát a Radeon R9 290X formájában. A kétchipes változat még egy kicsit gyorsabb is. A bonyolultabb pixel-pixel számításokkal végzett második résztesztben az új termék már 34%-kal gyorsabb a Geforce GTX 980-nál, ami közelebb áll a köztük lévő elméleti különbséghez. De a Titan X ezúttal már egy kicsivel gyorsabb, mint egy egyetlen Hawaiira épülő, egychipes feltételes versenytárs. Mivel a Radeon R9 295X2 két chipje tökéletesen működik, ez a feladat még gyorsabban teljesít rajta. Bár a matematikai számítások teljesítménye pixel shaderben magasabb a GCN architektúra chipeknél, a Maxwell architektúra megoldások megjelenése javította az Nvidia megoldások pozícióit. A könnyű tesszellációs résztesztben a nemrég bejelentett Nvidia kártya ismét csak negyeddel gyorsabb, mint a Geforce GTX 980 - a sebességet talán a memória sávszélessége korlátozza, hiszen a textúrának ebben a tesztben szinte semmi hatása nincs. Ha ebben a résztesztben az új terméket AMD lapokkal hasonlítjuk össze, akkor az Nvidia kártya ismét alulmúlja mindkét Radeont, mivel ebben a tesszellációs tesztben a háromszög hasítása nagyon mérsékelt, és a geometriai teljesítmény nem korlátozza az általános renderelési sebességet. A második tesszellációs teljesítményteszt egy újabb példa az ATI Radeon SDK - PN Triangles 3D fejlesztői számára. Valójában mindkét példa benne van a DX SDK-ban is, így biztosak vagyunk benne, hogy a játékfejlesztők ezek alapján készítik el saját kódjukat. Ezt a példát egy másik tessellációs tényezővel teszteltük, hogy megtudjuk, mennyire befolyásolja az általános teljesítményt.

Ebben a tesztben összetettebb geometriát alkalmazunk, ezért a különböző megoldások geometriai erejének összehasonlítása eltérő következtetéseket von le. Az anyagban bemutatott modern megoldások meglehetősen jól bírják a könnyű és közepes geometriai terheléseket, nagy sebességet mutatva. De míg a Hawaii egy és két GPU-ja a Radeon R9 290X-ben és R9 295X2-ben jól teljesít fényviszonyok között is, az Nvidia lapjai nagy igénybevétel esetén a legjobbak. A ma bemutatott Geforce GTX Titan X tehát a legnehezebb módokban már érezhetően jobban mutatja a sebességet, mint a kétlapkás Radeon. Ami a GM200 és GM204 chipekre épülő Nvidia kártyák összehasonlítását illeti, a ma vizsgált Geforce GTX Titan X modell a geometriai terhelés növekedésével növeli az előnyét, mivel világos módban minden a memória sávszélességétől függ. Ennek köszönhetően az új termék a mód összetettségétől függően akár 31%-kal is megelőzi a Geforce GTX 980 kártyát. Nézzük meg egy másik teszt, az Nvidia Realistic Water Terrain demóprogram, más néven Sziget eredményeit. Ez a demó tesszellációt és eltolásleképezést használ, hogy valósághű megjelenésű óceánfelszínt és terepet jelenítsen meg.

Az Island teszt nem pusztán szintetikus teszt a tisztán geometriai GPU teljesítmény mérésére, mivel összetett pixel- és számítási shadereket is tartalmaz, és egy ilyen terhelés közelebb áll azokhoz a valódi játékokhoz, amelyek minden GPU egységet használnak, és nem csak geometrikusakat, mint az előzőekben. geometriai tesztek. Bár a geometria feldolgozó egységek terhelése továbbra is a fő terhelés marad, például ugyanaz a memória sávszélessége is befolyásolhatja. Az összes videokártyát négy különböző tessellációs tényezővel teszteljük – ebben az esetben a beállítást Dynamic Tessellation LOD-nak hívják. Az első háromszög hasítási tényezővel a sebességet nem korlátozza a geometriai blokkok teljesítménye, és a Radeon videokártyák is meglehetősen magas eredményt mutatnak, különösen a két chipes R9 295X2, amely még a bejelentett Geforce GTX Titan X kártya eredményét is felülmúlja. , de már a következő geometriai terhelési szinteken csökken a Radeon kártyák teljesítménye, és az Nvidia megoldások vezetnek. A GM200 videochipre épülő új Nvidia kártya előnye riválisaival szemben az ilyen tesztekben már elég tisztességes, sőt többszörös. Ha összehasonlítjuk a Geforce GTX Titan X-et a GTX 980-al, akkor a teljesítményük közötti különbség eléri a 37-42%-ot, amit az elmélet tökéletesen megmagyaráz, és pontosan megfelel annak. A Maxwell GPU-k észrevehetően hatékonyabbak vegyes terhelés esetén, gyorsan váltanak a grafikus feladatokról a számítási feladatokra, és vissza, és a Titan X sokkal gyorsabb, mint a kétchipes Radeon R9 295X2 ebben a tesztben. Az új, csúcskategóriás GM200 GPU-n alapuló új Nvidia Geforce GTX Titan X videokártya szintetikus tesztjei eredményeinek elemzése, valamint a két különálló videochip gyártó más videokártya-modelljei eredményeinek elemzése után arra a következtetésre juthatunk, hogy a ma fontolóra vett videokártya legyen a leggyorsabb a piacon, versenyezve az AMD legerősebb kétchipes grafikus kártyájával. Általánosságban elmondható, hogy ez egy jó követője a Geforce GTX Titan Blacknek - egy erős egylapkás. Az Nvidia új grafikus kártyája elég erős eredményeket mutat a szintetikus anyagok terén - sok tesztben, bár nem mindenben. A Radeon és a Geforce hagyományosan eltérő erősséggel bír. Számos teszt során a Radeon R9 295X2 modell két GPU-ja gyorsabb volt, többek között a nagyobb általános memória sávszélesség és textúrázási sebesség miatt, valamint a számítási feladatok nagyon hatékony végrehajtása miatt. De más esetekben a Maxwell architektúra legjobb grafikus processzora nyer vissza, különösen a geometriai tesztekben és a tesszellációs példákban. A valódi játékalkalmazásokban azonban minden egy kicsit más lesz, mint a "szintetika" és a Geforce GTX Titan X-nek érezhetően nagyobb sebességet kell mutatnia, mint az egychipes Geforce GTX 980, és még inkább a Radeon R9 290X . Az újdonságot pedig nehéz összehasonlítani a kétchipes Radeon R9 295X2-vel - a két vagy több GPU-ra épülő rendszereknek megvannak a maguk kellemetlen tulajdonságai, bár megfelelő optimalizálás mellett az átlagos képkockasebesség növekedését biztosítják. De az építészeti jellemzők és a funkcionalitás egyértelműen az Nvidia prémium megoldása mellett szól. A Geforce GTX Titan X sokkal kevesebb energiát fogyaszt, mint ugyanaz a Radeon R9 295X2, az Nvidia új modellje pedig nagyon erős energiahatékonyság terén – ez a Maxwell architektúra jellegzetessége. Ne feledkezzünk meg az Nvidia új termékének nagyobb funkcionalitásáról: támogatja a DirectX 12 12.1-es funkciószintjét, a VXGI hardveres gyorsítást, az új MFAA élsimítási módszert és más technológiákat. A piaci nézőpontról már az első részben beszéltünk - az elit szegmensben már nem sok múlik az áron. A lényeg az, hogy a megoldás a lehető legfunkcionálisabb és produktívabb legyen a játékalkalmazásokban. Egyszerűen fogalmazva, mindenben ez volt a legjobb. Csak annak érdekében, hogy értékeljük az újdonság sebességét a játékokban, anyagunk következő részében meghatározzuk a Geforce GTX Titan X teljesítményét a játékprojekteinkben, és összehasonlítjuk a versenytársak teljesítményével, beleértve az indoklást is. az újdonság kiskereskedelmi árából a rajongók szemszögéből, és azt is megtudja, mennyivel gyorsabb a Geforce GTX 980 már a játékokban. |

Asus ProArt PA249Q monitor munkahelyi számítógéphez a cég által biztosított Asustek | A cég által biztosított Cougar 700K billentyűzet munkahelyi számítógéphez Puma |

A GeForce GTX Titan X videógyorsító jelenleg (2015. április) technológiailag a világ legfejlettebbje. Páratlan teljesítménnyel rendelkezik, amely páratlan a világon. A Titan X grafikus kártya professzionális és tapasztalt játékosok, valamint PC-rajongók számára készült. Az alaplap az NVIDIA új Maxwell architektúráján alapul, amelyet a Kepler GPU-k előző generációjához képest dupla teljesítmény és hihetetlen energiahatékonyság jellemez.

A GeForce GTX Titan X grafikus kártya a GM200 GPU-val van felszerelve, amely abszolút az összes 3072 CUDA magot tartalmazza, ami a GeForce GTX 900 termékcsalád maximális értéke.

Az innovatív GM200 GPU számos lenyűgöző tulajdonsággal rendelkezik játéktechnológiák, amelyeket a gyorsítók korábbi generációitól örököltek, és az NVIDIA mérnökei fejlesztették ki a semmiből. A 3D Vision 3D kijelzőket támogató jól ismert technológiák, a G-Sync adaptív szinkronizálás, valamint az MSAA és TXAA élsimítási algoritmusok mellett a GeForce GTX 900 család videokártyái bevezették a Multi-Frame Anti-Aliasing (MFAA) technológiát, amely garantálja 30%-os teljesítménynövekedés; élsimítási módszer ultra-nagy felbontású DSR használatával; valamint a Voxel Global Illumination (VXGI), amely felgyorsítja a dinamikus fényhatásokat, hogy magával ragadó élményt nyújtson. játékmenet filmes minőség.

Ez a gyorsító a sorozat többi kártyájához hasonlóan frissített NVIDIA GPU Boost 2.0 automatikus túlhajtási technológiát kapott, amely figyeli a videokártya működését, még hatékonyabban kezeli a GPU hőmérsékletét, a processzor túlhajtását és a feszültséget, ami lehetővé teszi a maximális GPU teljesítmény elérését. .

A termék NVIDIA Adaptive Vertical Sync technológiát tartalmaz. Ez a technológia nagy képkockasebességnél engedélyezve van a képszakadás kiküszöbölése érdekében, alacsony képkockasebességnél pedig letiltva, hogy minimalizálja a képkocka remegését.

A videokártya teljes körű működését a fejlesztő az új Microsoft DirectX 12 API-val garantálja, amely jelentősen csökkentheti a CPU terhelését és felgyorsíthatja a képmegjelenítést.

Összességében az új gyorsító tökéletes megoldás az ultranagy felbontású UHD 4K játékokhoz a legmagasabb minőségi beállítások mellett. Az egyre népszerűbb rendszerekben is megfelelő teljesítményt nyújt. virtuális valóság.

Előnyök

Végső teljesítmény A rajongók számára készült tökéletes teljesítményű megoldás lehetővé teszi, hogy a legújabb PC-játékokkal 4K felbontásban és a legjobb képminőségben játszhasson. Jelentős mozgástérrel rendelkezik a jövőbeli játékok számára. Az SLI támogatási csoportosítási képesség lehetővé teszi két-, három- és négykártya-konfigurációk létrehozását (SLI-kompatibilis alaplap használata esetén) a játékteljesítmény további javítása érdekében. További kijelzők csatlakoztatása Egyidejűleg használja a Dual-link DVI-t, HDMI-t és DisplayPort-ot a többmonitoros konfigurációkhoz akár 4 kijelzővel. Jó túlhajtás A kiforrott 28 nm-es GPU technológiának és a Maxwell architektúra nagy energiahatékonyságának köszönhetően a GeForce GTX Titan X grafikus kártya kiváló GPU túlhajtási képességekkel rendelkezik. A professzionális túlhajtások 2-szer tudják túlhajtani ennek a gyorsítónak a GPU-ját. Szép munka videóval Teljesen felgyorsított dekódolás az összes főbb videó formátumban, mind DVD / Blu-ray lemezeken, mind az internetről, kép a képben funkció támogatása, CUDA / OpenCL / DirectX gyorsítás támogatása videó kódolókhoz és szerkesztőkhöz, HEVC hardveres dekódolás . 3D Vision Stereo Ready A kártya több mint elegendő teljesítménnyel rendelkezik a teljes sztereó játékhoz az NVIDIA 3D Vision Kit használatakor (kompatibilis monitor szükséges). PhysX Acceleration Support A grafikus processzornak elegendő teljesítménye van a 3D grafika és a további speciális effektusok egyidejű kiszámításához a PhysX-kompatibilis játékokban. Alacsony energiafogyasztás Az új GPU architektúrának köszönhetően ez a videógyorsító a legmagasabb energiahatékonysággal rendelkezik. Ennek köszönhetően a működéséhez elegendő egy szerényebb táp (600 W-tól), mint az előző generáció csúcsmegoldásához, a GeForce GTX Titan Z gyorsítóhoz Virtuális valóságra készen A kártya VR Direct technológiával rendelkezik, amely speciálisan virtuális valóság-eszközökkel való együttműködésre tervezték. A fejlesztés több grafikus kártya SLI konfigurációban történő felhasználását foglalja magában, tartalmazza az Asynchronous Warp technológiát, amely csökkenti a képkéséseket és gyorsan beállítja a képet a fej forgásának megfelelően, valamint az Auto Stereo-t, amely növeli a játékok kompatibilitását a virtuális valóság eszközeivel. mint például az Oculus Rift.Hibák

Magas ár Az 1000 USD feletti költség jelentősen korlátozza a vásárlók körét. Magas rendszerkövetelmények A maximum érdekében hatékony felhasználása kártyák esetén egy „drága” PC-konfiguráció kívánatos, beleértve a modern alaplapot PCI Express 3.0 támogatással, a legerősebb központi processzort, a DDR4 memóriát és a PCI-e szilárdtestalapú meghajtót a játékok futtatásához.| Lapkakészlet |

|---|

A legfontosabb tudnivalók: A GeForce GTX TITAN X a leggyorsabb egylapkás játék grafikus kártya a piacon. Az NVIDIA új zászlóshajója elég gyors ahhoz, hogy hanyagul élvezze a modern 3D szórakoztatást Full HD és WQHD minőségben a legmagasabb grafikus beállítások mellett. Igaz, a GeForce GTX 980 is képes erre. „Várj, mi van a 4K-val?” - kérdezi az olvasó. Igen, bár a cikket „Az Ultra HD elsőnek” neveztem, de ami a modern, maximális grafikai minőségi beállításokkal rendelkező játékokat illeti, a GeForce GTX TITAN X csak feltételesen játszható FPS-szintet mutat. Ez azonban a legjobb mutató az egychipes videokártyák között. Ezért számomra személy szerint a GeForce GTX TITAN X az első olyan videokártya, amely valóban képes megfelelni a virtuális tereket ilyen nagy felbontásban meghódítani vágyó játékosok igényeinek. Hagyja, hogy bizonyos esetekben bele kell mélyednie a beállításokba. De néhány ilyen "titán" már képes megfékezni bármelyik következő következő generációt. Ha az illesztőprogramok és az optimalizálás nem okoz csalódást. Ez azonban egy külön cikk témája.

A 12 GB-os videomemória nagy biztonságot nyújt a GeForce GTX TITAN X számára. Persze valaki joggal mondja, hogy egy ilyen mennyiség felesleges. Ugyanaz az Assassin’s Creed Unity azonban 4K felbontásban, nem a nagyon-nagyon maximális grafikai minőségi beállítások mellett, már 5-6 GB videomemóriát „esz fel” a videokártyáról. Ez majdnem a fele. Éppen ezért (és ezt jól láttuk) még a több 3D-s gyorsítóból álló rendkívül drága köteg is szűk keresztmetszetet jelenthet a 4 GB-os GDDR5 formájában. Tehát az Ultra HD-ben való játékhoz most némi tartalékra van szükség.

Mint mindig, az NVIDIA hivatkozása jó dolognak bizonyult. A videokártya megfelelő túlhajtási potenciállal rendelkezik. Az elpárologtató alapú hűtő hatékonyan hűt egy 250 wattos chipet. Zajosan működik, de teljesen elviselhető.

Persze ha az NVIDIA tavaly szeptemberben adta volna ki ezt a videokártyát (de nem ~1000 dollárért – a szerző megjegyzése), akkor a wow-effektus szerintem erősebbnek bizonyult volna. Meg kell azonban lepődnünk az évek során kidolgozott NVIDIA rendszeren? GeForce GTX TITAN X vásárlásánál az ár a legerősebben korlátozó tényező. Hazánkban, amely újabb gazdasági válságot él át, még inkább.

Végezetül csak annyit jegyzem meg, hogy a "zöldek" elég magasra emelték a teljesítménylécet, amit a leendő AMD zászlóshajónak (Radeon R9 390X?) legalább a status quo visszaállításához el kell érnie. Vagy csináljon valami közeli teljesítményt, de érezhetően nagyobb költségvetést. Egyetértek, ezt nagyon érdekes lesz követni.

Az NVIDIA GeForce GTX TITAN X grafikus kártya elnyeri a Szerkesztők választási díját.

Előző Elite grafikus kártya NVIDIA GeForce GTX TITAN X 12 GB 2015 márciusában jelent meg, és a Maxwell 2.0 architektúrájú GM200 GPU-n alapult. Abban az időben az újdonságot a játékokhoz való videokártyákhoz való kolosszális mennyiségű videomemória, a nagyon nagy teljesítmény és a költség (999 dollár) jellemezte. A GeForce GTX TITAN X lendületes bravúrja azonban már három hónap után elhalványult, amikor a játékokban is ugyanolyan gyors GeForce GTX 980 Ti-t sokkal megfizethetőbb áron (649 dollár) mutatták be a nagyközönségnek.Úgy tűnik, hogy az NVIDIA úgy döntött, hogy megismétli ezt a bejelentési utat a top grafikus megoldások sorában, ami a „GeForce GTX 980 –> GeForce TITAN X –> GeForce GTX 980 Ti” sorozattal fejezhető ki, csak most a videokártyák alapjai Pascal architektúrájú GP104/102 magok, és 16 nm-es folyamattechnológiával készülnek. Az első videokártyával - NVIDIA GeForce GTX 1080 - mi már találkoztak, mint vele eredeti verziók. Itt az ideje, hogy felfedezzük az NVIDIA legújabb és fenomenális teljesítményű grafikus kártyáját, a TITAN X-et.

Az újdonság 200 dollárral kezdett többe kerülni, mint elődje - 1200 dollár, és természetesen továbbra is professzionális videokártyaként áll a kutatáshoz és a mélyreható tanuláshoz. De amint valószínűleg megérti, elsősorban a játékalkalmazásokban és a grafikus benchmarkokban való teljesítménye érdekel minket, mivel minden játékos nagyon várja a GeForce GTX 1080 Ti bejelentését, amelynek legújabb jelei már megfosztották a cég legnyilvánvalóbb híveit. az alvásról. Ma azonban az NVIDIA TITAN X-et külön számítási benchmarkokban teszteljük, hogy megbizonyosodjunk arról, hogy professzionális grafikus kártyaként használható.

1. NVIDIA TITAN X 12 GB szuper videokártya felülvizsgálata

a videokártya specifikációi és az ajánlott költségAz NVIDIA TITAN X videokártya műszaki jellemzői és költsége a táblázatban látható, összehasonlítva a referencia NVIDIA GeForce GTX 1080 és a GeForce GTX TITAN X régi verziójával.

csomagolás és felszerelés

Az NVIDIA szigorúan magának tartogatta a TITAN X kiadását, így a videokártya csomagolása alapfelszereltség: egy felnyitható kompakt doboz és egy antisztatikus tasakban a közepébe helyezett videokártya.

A csomagban nincs semmi, bár van benne egy további rekesz. Emlékezzünk vissza, hogy az NVIDIA TITAN X ajánlott ára 1200 USD.

PCB tervezés és jellemzők

Az új NVIDIA TITAN X dizájnja merészebb vagy még agresszívabb lett, mint a GeForce GTX TITAN X kialakítása. A videokártya elülső oldalán lévő hűtőrendszer burkolatát további élekkel látták el, amelyek a sugarak alatt tükröződnek. fény, a textolit hátoldalát pedig fémből készült hullámos borítás borította.

A krómozott ventilátorrotorral és az elülső oldalon ugyanazzal a felirattal együtt a videokártya igazán stílusos és vonzó. Ne feledje, hogy az NVIDIA TITAN X tetején a "GEFORCE GTX" izzó szimbólumok maradtak, bár ezek már nem szerepelnek a videokártya nevében.

A referencia videokártya 268 mm hosszú, 102 mm magas és 37 mm vastag.

A háromszög alakú lyukakkal perforált panel videokimenetei a következők: DVI-D, három DisplayPort 1.4-es verzió és egy HDMI 2.0b verzió.

Ebben a tekintetben az újdonság nem változott a GeForce GTX 1080-hoz képest.

A videokártyán két csatlakozó található a különféle SLI konfigurációk létrehozásához. A videokártyák kombinálására szolgáló 2-utas, 3-utas és 4-utas SLI-opciók támogatottak mind az új merev összekötő hidak, mind a régi rugalmas hidak használatával.

Ha a referencia GeForce GTX 1080 csak egy nyolctűs csatlakozóval rendelkezik a plusz teljesítményhez, akkor a TITAN X is kapott ezen felül egy hat tűs csatlakozót, ami nem meglepő, mert a videókártya deklarált fogyasztási szintje 250 watt, pl. az azt megelőző GeForce GTX TITAN X. Az ajánlott tápegység egy ilyen videokártyával rendelkező rendszerhez legalább 600 watt legyen.

A referencia NVIDIA TITAN X PCB sokkal összetettebb, mint a GeForce GTX 1080 kártya, ami a megnövekedett teljesítményigény, a megnövelt videomemória és a vele egy szélesebb kommunikációs busz ismeretében teljesen logikus.

A GPU táprendszere ötfázisú, Dr.MOS tápelemekkel és tantál-polimer kondenzátorokkal. Két további energiafázis van a videomemóriának szentelve.

Az uPI Semiconductor uP9511P vezérlője felelős a GPU energiagazdálkodásáért.

A megfigyelési funkciókat a Texas Instruments által gyártott INA3221 vezérlő biztosítja.

A 16 nm-re készült, 471 mm2-es GP102 GPU matrica 2016. 21. héten (május végén) jelent meg, és az A1 verzióhoz tartozik.

Az NVIDIA GeForce GTX TITAN X GPU GM200-hoz képest az új GP102 16,7%-kal több univerzális shader processzort tartalmaz, és ezek száma összesen 3584. A mutató előnye a GeForce GTX GP104 1080-hoz képest. lenyűgöző 40%. Ugyanez az igazítás a textúra egységek számát tekintve is, amiből az új TITAN X 224 darabot tartalmaz. A GP102 számokat 96 Raster Operations Units (ROP) egészíti ki.

A GPU-frekvenciák is növekedtek. Ha a GeForce GTX TITAN X alap GPU-frekvenciája 3D módban 1000 MHz, és 1076 MHz-ig volt felerősíthető, akkor az új TITAN X alapfrekvenciája 1418 MHz (+41,8%), és a deklarált boost frekvencia 1531 MHz. Valójában a megfigyelési adatok szerint a GPU frekvenciája rövid időre 1823 MHz-re nőtt, és átlagosan 1823 MHz volt. Ez igen jelentős növekedés elődjéhez képest. Hozzátesszük, hogy 2D módra váltva a GPU frekvenciája 139 MHz-re csökken, miközben a feszültség egyidejűleg 1,050 V-ról 0,781 V-ra csökken.

Az NVIDIA TITAN X 12 GB GDDR5X memóriával van felszerelve, amely tizenkét Micron chippel van összeszerelve (6KA77 D9TXS jelzéssel), és csak a nyomtatott áramköri lap elülső oldalára van forrasztva.

A korábbi GeForce GTX TITAN X-hez képest GM200-on a GP102-es új TITAN X memóriafrekvenciája 10008 MHz, ami 42,7%-kal magasabb. Így a változatlan, 384 bites memóriabusz-szélesség mellett a TITAN X memória sávszélessége lenyűgöző 480,4 GB/s-ot ér el, ami csak valamivel kevesebb, mint a jelenlegi rekorder ezen a területen - az AMD Radeon R9 Fury X nagy sebességű HBM-mel és 512 GB/s 2D módban a memória frekvenciája 810 effektív megahertzre csökken.

Az új videokártya hardverének felülvizsgálatának eredményét a GPU-Z segédprogramból származó információk összegzik.

A videokártya BIOS-át is közzétesszük, beolvasva és elmentve ugyanazzal a segédprogrammal.

hűtőrendszer - hatékonyság és zajszint

Az NVIDIA TITAN X hűtőrendszer megegyezik az NVIDIA GeForce GTX 1080 Founders Edition hűtővel.

Alapja egy nikkelezett alumínium hűtőborda, amelynek alján réz elpárologtató kamra található, amely a GPU hűtéséért felel.

Ez a radiátor kis területű, és a bordaközi távolság nem haladja meg a két millimétert.

Így nem nehéz feltételezni, hogy a GPU hűtésének hatékonysága ezzel a radiátorral komolyan függ a ventilátor sebességétől (amit később megerősítettek).

A memória chipek és a tápáramkörök elemeinek hűtésére hőpárnákkal ellátott fémlemez található.

A videokártya hőmérsékleti rendszerének terhelésként történő ellenőrzéséhez a Fire Strike Ultra stresszteszt tizenkilenc ciklusát használtuk a 3DMark csomagból.

A hőmérséklet és minden egyéb paraméter figyelésére az MSI Afterburner 4.3.0 Beta 14 és újabb verzióit, valamint a GPU-Z segédprogram 1.12.0-s verzióját használtuk. Teszteket végeztek a rendszeregység zárt tokban, melynek konfigurációját a cikk következő részében láthatja, szobahőmérsékleten 23,5~23,9 Celcius fok.

Először is teszteltük az NVIDIA TITAN X hűtési hatékonyságát és hőteljesítményét teljesen automatikus ventilátorsebesség-szabályozással.

Automata üzemmód (1500-3640 ford./perc)

Ahogy a monitorozási grafikonon is látszik, az NVIDIA TITAN X GPU hőmérséklete nagyon gyorsan elérte a 88-89 Celsius fokot, majd a ventilátor fordulatszámának relatíve meredek 1500-ról 3500 ford./percre növekedése miatt 86 fok körül stabilizálódott. Celsius. A teszt során a ventilátor fordulatszáma tovább nőtt 3640 ford./percre. Nem valószínű, hogy bármelyikünk más hőmérsékleti mutatókat várt egy 250 wattos hőcsomaggal rendelkező referencia videokártyától, amelyek gyakorlatilag nem különböznek a GeForce GTX TITAN X-től.

Maximális ventilátorsebesség mellett az NVIDIA TIAN X grafikus kártya grafikus processzorának hőmérséklete 12-13 Celsius-fokkal csökken az automatikus beállítási módhoz képest.

Maximális fordulatszám (~4830 ford./perc)

Mindkét ventilátor módban az NVIDIA TITAN X egy nagyon zajos grafikus kártya. Az NVIDIA egyébként nem fosztja meg ennek a videokártya-modellnek a tulajdonosait a garanciától, amikor a referenciahűtőt alternatívakra cserélik.

túlhajtási potenciál

Az NVIDIA TITAN X túlhajtási potenciáljának ellenőrzésekor a maximálisan lehetséges 120%-kal megemeltük a teljesítménykorlátot, a hőmérsékleti határt 90 Celsius-fokra, a ventilátor fordulatszámát pedig manuálisan 88%-os teljesítményre vagy 4260 ford./percre rögzítettük. Több órás tesztelés után sikerült rájönnünk, hogy stabilitásvesztés és képhibák megjelenése nélkül a grafikus processzor alapfrekvenciája 225 MHz-cel (+ 15,9%) növelhető, illetve a videomemória effektív frekvenciája. 1240 MHz-cel (+ 12,4%).

Ennek eredményeként a túlhúzott NVIDIA TITAN X frekvenciája 3D módban elérte a 1643-1756/11248 MHz.

A túlhúzott videokártya hőmérsékleti tesztje során a GPU-frekvenciák jelentős elterjedése miatt a 3DMark csomagból származó teszt ismét a TITAN X instabilitásáról számolt be.

Ennek ellenére a teszt mind a 19 ciklusát, valamint a tesztkészlet összes játékát sikeresen teljesítették, és a megfigyelési adatok szerint a túlhúzott videokártya magfrekvenciája 1987 MHz-re nőtt.

88% teljesítmény (~4260 ford./perc)

Tekintettel a referencia NVIDIA TITAN X túlhajtására, feltételezhetjük, hogy az eredeti GeForce GTX 1080 Ti még jobban túlhajtja. Azonban az idő eldönti.

2. Tesztkonfiguráció, eszközök és tesztelési módszertan

A videokártyákat a következő konfigurációjú rendszeren tesztelték:

alaplap: ASUS X99-A II (Intel X99 Express, LGA2011-v3, BIOS 1201, 2016.10.11-től);

CPU: Intel Core i7-6900K (14 nm, Broadwell-E, R0, 3,2 GHz, 1,1 V, 8 x 256 KB L2, 20 MB L3);

CPU hűtőrendszer: Phanteks PH-TC14PE (2 Corsair AF140, ~900 rpm);

termikus interfész: ARCTIC MX-4 (8,5 W/(m*K));

RAM: DDR4 4 x 4 GB Corsair Vengeance LPX 2800MHz (CMK16GX4M4A2800C16) (XMP 2800MHz/16-18-18-36_2T/1,2V vagy 3000MHz/16-16_2VT)

videokártyák:

NVIDIA TITAN X 12 GB 1418-1531(1848)/10008MHz és 1643-1756(1987)/11248MHz-re túlhajtva;

Gigabyte GeForce GTX 1080 G1 Gaming 8 GB 1607-1746(1898)/10008 MHz és 1791-1930(2050)/11312 MHz-re túlhajtva;

NVIDIA GeForce GTX 980 Ti 6 GB 1000-1076 (1189)/7012 MHz és 1250-1326 (1437)/8112 MHz-re túlhajtva;

lemez rendszerhez és játékokhoz: Intel SSD 730 480 GB (SATA-III, BIOS vL2010400);

benchmark meghajtó: Western Digital VelociRaptor (SATA-II, 300 GB, 10 000 rpm, 16 MB, NCQ);

biztonsági lemez: Samsung Ecogreen F4 HD204UI (SATA-II, 2 TB, 5400 rpm, 32 MB, NCQ);

hangkártya: Auzen X-Fi HomeTheater HD;

ház: Thermaltake Core X71 (négy legyen csendes! Silent Wings 2 (BL063) 900 ford./percnél);

vezérlő- és felügyeleti panel: Zalman ZM-MFC3;

Tápegység: Corsair AX1500i Digital ATX (1500 W, 80 Plus Titanium), 140 mm-es ventilátor;

Monitor: 27 hüvelykes Samsung S27A850D (DVI, 2560 x 1440, 60 Hz)

Természetesen a TITAN X videokártya korábbi verziói nem tudtuk a kezünkbe, így két másik videókártyával fogjuk összehasonlítani az új terméket, de egyáltalán nem lassúkkal. Ezek közül az első az eredeti Gigabyte GeForce GTX 1080 G1 Gaming lesz, amit a referencia NVIDIA GeForce GTX 1080 frekvenciáin, valamint 1791-1930/11312 MHz-re túlhajtva teszteltünk.

Vegye figyelembe, hogy a videokártya grafikus processzorának csúcsfrekvenciája a túlhajtás során elérte a 2050 MHz-et.

A második tesztkártya a referencia NVIDIA GeForce GTX 980 Ti, melynek teljesítményét névleges frekvencián és 1250-1326(1437)/8112 MHz-re túlhajtva is teszteltük.

Mivel a megjelenéskor a játékokban a GeForce GTX 980 Ti a korábbi GeForce GTX TITAN X teljesítményével megegyező teljesítményt mutatott, ez az összehasonlítás két különböző TITAN X összehasonlításának tekinthető. Hozzátesszük, hogy az összes videokártya teljesítmény- és hőmérsékleti korlátai a lehető legnagyobbra növelték, és a GeForce illesztőprogramok a legmagasabb teljesítményprioritásra lettek állítva.

A videokártya teljesítményének platformsebességtől való függőségének csökkentése érdekében a 14 nm-es nyolcmagos processzort 40-es szorzóval, 100 MHz-es referenciafrekvenciával és a harmadik szintre aktivált Load-Line Calibration funkcióval túlhúzták. 4,0 GHz amikor az alaplap BIOS-ában a feszültség 1,2095 V-ra emelkedik.

Míg 16 gigabájt véletlen hozzáférésű memória frekvencián működnek 3,2 GHz időzítésekkel 16-16-16-28CR1 1,35 V feszültségen.

A 2016. október 20-án megkezdett tesztelés a Microsoft Windows 10 Professional operációs rendszerrel, az adott dátum összes frissítésével és a következő telepített illesztőprogramokkal történt:

alaplapi lapkakészlet Intel lapkakészlet illesztőprogramok - 10.1.1.38 WHQL, 2016.10.12;

Intel Management Engine Interface (MEI) - 1025.06.11. WHQL, 2016.10.14.;

NVIDIA grafikus kártya illesztőprogramok - GeForce 375.57 WHQL 2016.10.20-tól.

Mivel a mai tesztek videókártyái nagyon produktívak, úgy döntöttek, hogy elutasítják az 1920 x 1080 pixeles felbontású teszteket, és csak 2560 x 1440 pixeles felbontást használtak. A felbontások még nagyobbak, sajnos a meglévő monitor nem támogatja. A legutóbbi frissítések eredményeit figyelembe véve azonban nem kell sajnálni, hogy nem érhetők el a nagyobb felbontások. A tesztekhez két grafikai minőségi módot használtunk: Minőség + AF16x - alapértelmezés szerint textúraminőség az illesztőprogramokban 16x anizotrop szűréssel és Minőség + AF16x + MSAA 4x (8x) 16x anizotrop szűréssel és 4x vagy 8x teljes képernyős élsimítással , olyan esetekben, amikor az átlagos képkocka másodpercenként elég magas maradt egy kényelmes játékhoz. Egyes játékokban a játékmotorok sajátosságaiból adódóan más élsimító algoritmusokat is alkalmaztak, amelyeket a későbbiekben a módszertanban és az ábrákon jelezni fogunk. Az anizotróp szűrést és a teljes képernyős élsimítást közvetlenül a játék beállításaiban engedélyezték. Ha ezek a beállítások nem voltak elérhetők a játékokban, akkor a paraméterek megváltoztak a GeForce illesztőprogram vezérlőpultján. A függőleges szinkronizálást (V-Sync) ott is erőszakkal letiltották. A fentieken kívül további változtatások nem történtek az illesztőprogram beállításaiban.

A grafikus kártyákat egy grafikus tesztben, egy VR-tesztben és tizenöt játékban tesztelték legújabb verziói az anyag elkészítésének megkezdésének napján. Az előzőhöz képest videokártya teszt a tesztkészletből nem szerepelt a régi és erőforrásigényes Thief and Sniper Elite III, de benne volt az új Total War: WARHAMMER és a Gears of War 4 DirectX 12 API támogatással (most már öt ilyen játék van a készletben). Emellett a következő videókártyákról szóló cikkekben egy újabb, DirectX 12 API-t támogató játék jelenik meg a listában, tehát most így néz ki a tesztalkalmazások listája (a játékok és a bennük lévő további teszteredmények a hivatalos kiadásuk sorrendje):

3DMark(DirectX 9/11) – 2.1.2973 verzió, Fire Strike, Fire Strike Extreme, Fire Strike Ultra és Time Spy jelenetekben tesztelve (a grafikus pontszám a diagramon látható);

SteamVR– teszt a „virtuális valóság” támogatására, az eredmény a teszt során tesztelt képkockák száma;

Crysis 3(DirectX 11) - 1.3.0.0 verzió, minden grafikai minőségi beállítás maximumon, elmosódási szint közepes, vakítás engedélyezett, üzemmódok FXAA-val és MSAA-val 4x, a Swamp küldetés kezdetétől 105 másodpercig tartó forgatókönyvezett jelenet dupla szekvenciális átadása;

Metró utolsó fény(DirectX 11) - 1.0.0.15-ös verzió, beépített teszt, grafikai minőségi beállítások és tesszelláció nagyon magas szinten, fejlett PhysX technológia két tesztelési módban, tesztek SSAA-val és élsimítás nélkül, a D6 jelenet dupla szekvenciális futtatása;

Battlefield 4(DirectX 11) – 1.2.0.1-es verzió, az Ultra összes grafikai minőségi beállítása, a forgatókönyvezett jelenet dupla szekvenciális futtatása a TASHGAR küldetés kezdetétől, 110 másodpercig;

Grand Theft Auto V(DirectX 11) - build 877, Nagyon jó minőségű beállítások, Javasolt korlátok figyelmen kívül hagyása engedélyezve, V-Sync letiltva, FXAA engedélyezve, NVIDIA TXAA letiltva, MSAA tükröződések letiltva, NVIDIA lágy árnyékok;

DiRT Rally(DirectX 11) - 1.22-es verzió, az Okutama pályán a játékba épített tesztet használták, a grafikai minőség beállításait minden elemnél a maximális szintre állítottuk, Advanced Blending - On; tesztek MSAA 8x-tal, élsimítás nélkül;

Batman: Arkham Knight(DirectX 11) – 1.6.2.0-s verzió, minőségi beállítások magas, textúrafelbontás normál, élsimítás be, V-Sync letiltva, tesztelés két módban – az utolsó két NVIDIA GameWorks opció aktiválásával és anélkül, dupla szekvenciális futtatás a tesztjátékba beépített;

(DirectX 11) - 4.3-as verzió, textúra minőségi beállítások nagyon magasra, Texture Filtering - Anisotropic 16X és egyéb maximális minőségi beállítások, tesztek MSAA-val 4x és élsimítás nélkül, a játékba épített teszt dupla szekvenciális futtatása.

A Tomb Raider felemelkedése(DirectX 12) - 1.0-s verzió, build 753.2_64, minden paraméter nagyon magasra állítva, Dynamic Foliage - High, Ambient Occlusion - HBAO+, tesselláció és egyéb minőségjavító technikák aktiválva, a beépített benchmark teszt két ciklusa (Geothermal Valley jelenet) élsimítás nélkül és SSAA 4.0 aktiválással;

Far Cry Primal(DirectX 11) - 1.3.3-as verzió, maximális minőségi szint, nagy felbontású textúrák, térfogati köd és árnyékok maximálisan, beépített teljesítményteszt élsimítás nélkül és aktivált SMAA-val;

Tom Clancy's The Division(DirectX 11) - 1.4-es verzió, maximális minőségi szint, minden képjavítási paraméter aktiválva van, Temporal AA - Supersampling, tesztmódok élsimítás nélkül és SMAA 1X Ultra aktiválással, beépített teljesítményteszt, de FRAPS eredmények rögzítése;

Bérgyilkos(DirectX 12) - 1.5.3-as verzió, beépített teszt "Ultra" grafikai minőségi beállításokkal, SSAO engedélyezve, árnyékminőség "Ultra", memóriavédelem letiltva;

Deus Ex: Az emberiség megosztott(DirectX 12) - 1.10-es verzió, 592.1-es verzió, minden minőségi beállítás manuálisan a maximális szintre van állítva, a tesszelláció és a mélységélesség aktiválva van, a játékba épített benchmark legalább két egymást követő futtatása;

Total War: WARHAMMER(DirectX 12) – 1.4.0-s verzió, 11973.949822 build, minden grafikai minőség beállítás a maximális szintre, tükröződések engedélyezettek, korlátlan videomemória és SSAO aktiválva, a játékba épített benchmark kettős szekvenciális futtatása;

Gears of War 4(DirectX 12) - 9.3.2.2-es verzió, minőségi beállítások Ultra-n, V-Sync letiltva, minden effektus engedélyezve, 150%-os felbontású skálázás (3840 x 2160-ig) a játék által nem támogatott élsimítás helyett, dupla szekvenciális futtatás a játékba épített benchmark .

Ha a játékok megvalósították a másodpercenkénti minimális képkockaszám rögzítésének lehetőségét, akkor ez a diagramokon is tükröződött. Mindegyik tesztet kétszer végeztük el, a két kapott érték közül a legjobbat vettük végeredménynek, de csak akkor, ha a különbség nem haladta meg az 1%-ot. Ha a tesztfutások eltérései meghaladták az 1%-ot, akkor a megbízható eredmény érdekében a tesztelést még legalább egyszer megismételték.

3. Teljesítményvizsgálati eredmények

A diagramokon a videokártyák túlhúzás nélküli tesztelésének eredményei zölddel, túlhúzással pedig sötét türkizzel vannak kiemelve. Mivel a diagramokon szereplő összes eredmény közös mintázatot mutat, ezért nem kommentálunk mindegyiket külön, hanem az összefoglaló diagramokat elemezzük a cikk következő részében.3DMark

SteamVR

Crysis 3

Metró utolsó fény

Battlefield 4

Grand Theft Auto V

DiRT Rally

Batman: Arkham Knight

Tom Clancy's Rainbow Six: Siege

A Tomb Raider felemelkedése

Far Cry Primal

Tom Clancy's The Division

Bérgyilkos

Deus Ex: Az emberiség megosztott

Total War: WARHAMMER

Mivel most először teszteljük a Total War: WARHAMMER-t, ma és a videókártyákról szóló további cikkeinkben megadjuk azokat a beállításokat, amelyeken a játék tesztelésre kerül.

És akkor az eredmények.

Gears of War 4

A beállításokat is megadjuk új játék A Gears of War 4 először szerepel a tesztkészletben.

Az eredmények a következők.

Az elkészített diagramokat egészítsük ki egy záró táblázattal, amely teszteredményeket tartalmaz az egyes videokártyák másodpercenkénti képkockaszámának származtatott átlagával és minimális értékeivel.

A sorban következnek az összefoglaló diagramok és az eredmények elemzése.

4. Összefoglaló diagramok és eredmények elemzése

Az első pár összefoglaló diagramban azt javasoljuk, hogy az új NVIDIA TITAN X 12 GB névleges frekvencián és a referencia NVIDIA GeForce GTX 980 Ti 6 GB teljesítményét névleges frekvenciákon is összehasonlítsuk. Kiindulási pontnak az utolsó videokártya eredményeit vesszük, és ennek százalékában félretesszük az NVIDIA TITAN X videokártya átlagos FPS-ét. Az új grafikus kártya előnye kétségtelenül lenyűgöző.

Tesztkörülményeink és beállításaink szerint az NVIDIA TITAN X legalább 48%-kal gyorsabb, mint az NVIDIA GeForce GTX 980 Ti, és elképesztő 85%-os csúcsot ér el! Figyelembe véve, hogy a játékokban a GeForce GTX 980 Ti valójában megegyezett az előző GeForce TITAN X-szel, elmondhatjuk, hogy az NVIDIA TITAN X ugyanolyan gyorsabb, mint elődje. Egy teljes értékű Pascal GPU előrehaladása hihetetlen, kár, hogy eddig mindez nagyon drága, de a már a láthatáron pislákoló GeForce GTX 1080 Ti is érezhetően olcsóbb lesz (a kérdés csak az, hogy pontosan mit fognak vágni ?). Tehát átlagosan minden játék esetében 2560 x 1440 pixeles felbontás mellett az NVIDIA TITAN X 64,7%-kal gyorsabb, mint az NVIDIA GeForce GTX 980 Ti élsimítás nélküli módokban, és 70,4%-kal, ha különböző élsimító algoritmusokat aktiválnak.

Most pedig értékeljük, hogy az NVIDIA TITAN X mennyivel előzi meg a Gigabyte GeForce GTX 1080 G1 Gamingot névleges frekvenciákon a GeForce GTX 1080 referenciaverzióinak szintjére hozott frekvenciaképlettel.

Ismét egy nagyon tisztességes teljesítménynövekedés! Az új termék legalább 19%-kal gyorsabb, mint a GeForce GTX 1080, a Rise of Tomb Raiderben pedig eléri a lenyűgöző 45,5%-ot. Az összes játékban átlagosan az NVIDIA TITAN X 27,0%-kal gyorsabb élsimítás nélküli módokban, és 32,7%-kal gyorsabb, ha az élsimítás engedélyezett.

Most arról álmodozunk, hogy az NVIDIA a GeForce GTX 1080 Ti kiadásakor nem a blokkszámban és a shader processzorok számában vágja le a Pascal csúcsát, ugyanakkor partnerei megnövelt frekvenciával adják ki az eredeti verziókat. Mennyivel nő még ebben az esetben a zászlóshajó teljesítménye? A válasz a következő összefoglaló táblázatban található.

Az NVIDIA TITAN X 15,9%-os túlhajtása a magon és 12,4%-kal a videomemórián, 12,9%-kal gyorsítja az amúgy is lélegzetelállítóan gyors videokártyát élsimítás nélküli módokban és 13,4%-kal, ha az AA engedélyezve van. Ha visszatérünk az első összefoglaló diagramhoz, könnyen feltételezhető, hogy az eredeti GeForce GTX 1080 Ti kétszer olyan gyorsan referencia GeForce GTX 980 Ti vagy GeForce GTX TITAN X. Természetesen egy ilyen összehasonlítás nem objektív, mert mindenki tudja, hogy az eredeti GeForce GTX 980 Ti sokszor akár 1,45-1,50 GHz-es túlhajtásra is képes a magon, ami az előnyt jelenti. A potenciális GeForce GTX 1080 Ti nem lesz olyan magas. Ennek ellenére az előző generáció zászlóshajójához képest még 60-70%-os teljesítménynövekedés is lenyűgöz. Hol van nálam hasonló növekedés a központi processzorokban vagy a RAM-ban? Ilyen még a legfelső szegmensben sincs. És az NVIDIA már rendelkezik ilyen képességekkel!

5. GPU számítástechnika

Először is teszteljük az új NVIDIA TITAN X videokártya teljesítményét a CompuBench CL 1.5.8-as verziójában. Az első két teszt a Viola-Jones algoritmuson és a TV-L1 Optical Flow mozgásvektor számításán alapuló arcfelismerés.

Az NVIDIA TITAN X teljesítménye ismét lenyűgöző. Névleges üzemmódban az újdonság az Arcfelismerés tesztben 66,6%-kal, a TV-L1 Optical Flow benchmarkban pedig 90,4%-kal előzi meg a referencia GeForce GTX 980 Ti-t. A GeForce GTX 1080-zal szembeni előny is elég szembetűnő, és az új Titan túlhajtása további 8,1-12,1%-kal gyorsítja ezt a videókártyát. Körülbelül ugyanilyen teljesítménynövekedés volt megfigyelhető a másik két, növekvő frekvenciával tesztelt videokártyán is.

A következő a sorban az Ocean Surface Simulation teszt a vízfelszíni hullámok mozgásának megrajzolására a gyors diszkrét Fourier-transzformáció segítségével, valamint a Részecskeszimulációs teszt a részecskék fizikai szimulációjához.

A tesztpár jellegzetessége a GeForce GTX 980 Ti és a GeForce GTX 1080 eredményeinek viszonylagos közelsége volt, úgy tűnik, a Maxwell mag nem adja könnyen magát. De az új TITAN X előtt mindkét videókártya megadja magát, 42,6-ról 54,4%-ra veszít.

Sokkal sűrűbb eredmények a Videó kompozíció tesztben.

A túlhúzott Gigabyte GeForce GTX 1080 G1 Gaming még a névleges NVIDIA TITAN X-et is sikerül utolérnie, bár utóbbi húsz százalékos előnyt mutat a GeForce GTX 980 Ti-vel szemben.

De a Bitcoin bányászat szimulációjában ismét láthatjuk az NVIDIA TITAN X óriási előnyét.

Az új termék majdnem kétszer olyan gyors, mint a GeForce GTX 980 Ti, és 30,4%-kal gyorsabb, mint a Gigabyte GeForce GTX 1080 G1 Gaming a referencia NVIDIA GeForce GTX 1080 frekvenciáin. Ilyen ütemű teljesítménynövekedés mellett az NVIDIA és a videokártyák az AMD-n a grafikus processzoroknak nagyon kevés marad.

A következő a sorban a GPGPU teszt az AIDA64 Extreme segédprogram 5.75.3981 Beta verziójából. A kapott eredményekből diagramokat építettünk az egyszeres és kettős pontosságú lebegőpontos műveletekhez.

Ha a korábbi NVIDIA GeForce GTX TITAN X ezekben a tesztekben 62%-kal megelőzte a GeForce GTX TITAN első verzióját, akkor a Pascal magon lévő új TITAN X egyszerre 97,5%-kal felülmúlja elődjét! Az AIDA64 GPGPU teszt bármely más eredményét a fórumban található cikk vitaszálában találja.

Végezetül teszteljük a legújabb LuxMark 3.1 legösszetettebb jelenetét – a Hotel Lobbyt.

Vegye figyelembe, hogy a régi GeForce GTX 980 Ti "nem adja fel" a Gigabyte GeForce GTX 1080 G1 Gaminget ebben a tesztben, de a TITAN X azonnal 58,5%-kal felülmúlja azt. Fenomenális teljesítmény! Ennek ellenére kár, hogy az NVIDIA továbbra is késlelteti a GeForce GTX 1080 Ti megjelenését, és különösen kár, hogy ebben még senki nem nyomja.

6. Energiafogyasztás

Az energiafogyasztás mértékét a Corsair AX1500i tápegység segítségével, a Corsair Link interfészen keresztül és az azonos nevű program 4.3.0.154-es verziójával mértük. A teljes rendszer energiafogyasztását mérték, a monitor kivételével. A mérést 2D módban, normál munkavégzés közben, Microsoft Word vagy Internet böngészés közben, valamint 3D módban végeztük. Az utóbbi esetben a terhelést a Crysis 3 játék Swamp szintű bevezető jelenetének négy egymást követő ciklusával hozták létre 2560 x 1440 pixeles maximális grafikai minőségi beállítások mellett, MSAA 4X használatával. A CPU energiatakarékos technológiái le vannak tiltva.Hasonlítsuk össze a diagramon a rendszerek energiafogyasztását a ma tesztelt videokártyákkal.

Annak ellenére, hogy a teljesítmény mindenhol és mindenhol hatalmasat nőtt, az NVIDIA-nak sikerült a Pascal magos új TITAN X hőcsomagját a TITAN X előző verziójával megegyező korlátok között tartani - 250 watt, így az ezekkel a videókkal rendelkező rendszerek energiafogyasztása kártyák nem különböznek lényegesen. Tehát névleges módban az NVIDIA TITAN X konfigurációja 41 wattal többet fogyaszt, mint az NVIDIA GeForce GTX 980 Ti videokártya, és mindkét videokártya túlhajtása esetén ez a különbség 23 wattra csökken. Ugyanakkor megjegyezzük, hogy a Gigabyte GeForce GTX 1080 G1 Gaming rendszer gazdaságosabb, mint a TITAN X mindkét verziója, és a referencia GeForce GTX 1080 frekvenciáin majdnem a 400 wattos határon belül van, és ez figyelembe véve azt a tényt, hogy a konfiguráció egy megfelelően túlhajtható nyolcmagos processzort tartalmaz. Gazdaságosabb újdonság 2D módban.

Következtetés

Mivel ma a GeForce GTX 1080 és GTX 1070 mellett az NVIDIA videokártyák foglalják el az egyedüli vezető szerepet a teljesítmény tekintetében a felső árszegmensben, a még produktívabb TITAN X megjelenését tekinthetjük a technológiai fölény legjobb bizonyítékának. az egyetlen versenyző. Ráadásul ez a bemutató teljesen sikeres volt, mert ugyanabban a hőcsomagban lévén az újdonság előnye az előző generáció zászlóshajó NVIDIA videokártyájával szemben a játékteszteken néha eléri a 85%-ot, átlagosan pedig körülbelül 70%-ot! Nem kevésbé lenyűgöző a számítástechnika teljesítményének növekedése, ami, mint tudjuk, az NVIDIA TITAN sorozatú videokártyák esetében a legfontosabb.A teljesítménykülönbség a GeForce GTX 1080-hoz képest valamivel szerényebb és 27-33%-ot tesz ki, de a túlhajtásból származó teljesítménynövekedés magasabb a TITAN X esetében (körülbelül 13% a GeForce GTX 1080 esetében 10%-kal szemben), ami azt jelenti, hogy amikor a GeForce GTX 1080 Ti ugyanazon GP102 alapján jelenik meg, jogunk van még magasabb frekvenciákkal és ennek eredményeként a teljesítmény növekedésével számolni. A TITAN X közleményében a negatív pont az ajánlott költség kétszáz dolláros emelése, azonban véleményünk szerint a 20%-os költségnövekedés nem okoz komoly gondot az ilyen videokártyák potenciális fogyasztóinak. Nos, a szerényebb játékosok már nagyon várják a GeForce GTX 1080 Ti megjelenését, valamint „piros” vetélytársát.

Ezenkívül megjegyezzük, hogy a játékokban nyújtott lenyűgöző teljesítmény ellenére az NVIDIA maga a TITAN X-et mindenekelőtt hatékony eszköznek tekinti a neurális hálózatok képzésében és a Deep Learning algoritmusokkal kapcsolatos problémák megoldásában (deep learning). Ezeket az algoritmusokat ma már aktívan használják különféle területeken: beszéd-, kép-, videofelismerés, hidrometeorológiai előrejelzés, pontosabb orvosi diagnózisok, nagy pontosságú térképezés, robotika, önvezető autók stb. Ezért elmondhatjuk, hogy az új NVIDIA TITAN X videokártya lehetőségei korlátlanok, és minden felhasználót kielégítenek.

Köszönjük az NVIDIA-nak és személyesen Irina Shekhovtsovának

a teszteléshez biztosított videokártyához.